2 dni temu zacząłem pisać cały artykuł, o tym dlaczego branie Google PSI w 100% na poważnie jest abstrakcją i mitem, zbudowanym przez agencje SEO do zwiększania sprzedaży optymalizacji i pozycjonowania.

Uprzedził mnie jednak Łukasz Szmigiel i stwierdziłem, że to bezcelowe.

Wersja Audio:

Google Page Speed Insight – Mit i kit

Zanim jednak odeślę Ciebie do kompleksowego wyjaśnienia dlaczego Page Speed Insight jest słabym narzędziem do oceny optymalizacji witryny pozwolę sobie wrzucić kilka swoich uwag:

- Strona, na której dążymy do 100/100 często lądują się… wolniej przez ich przeoptymalizowanie,

- Często wdrożenie niektórych rozwiązań generuje wiele błędów np. Javascript a efekt jaki uzyskujemy to może 0.5sek więcej,

- Zalecenia tam to tylko sugestie, a nie sposób na TOP10 – owszem prędkość ma znaczenie, ale realna (można ją sprawdzić np. W Pingdom lub Google Analytics) – punktacja często mija się z realną prędkością (zdjęcie na końcu wpisu),

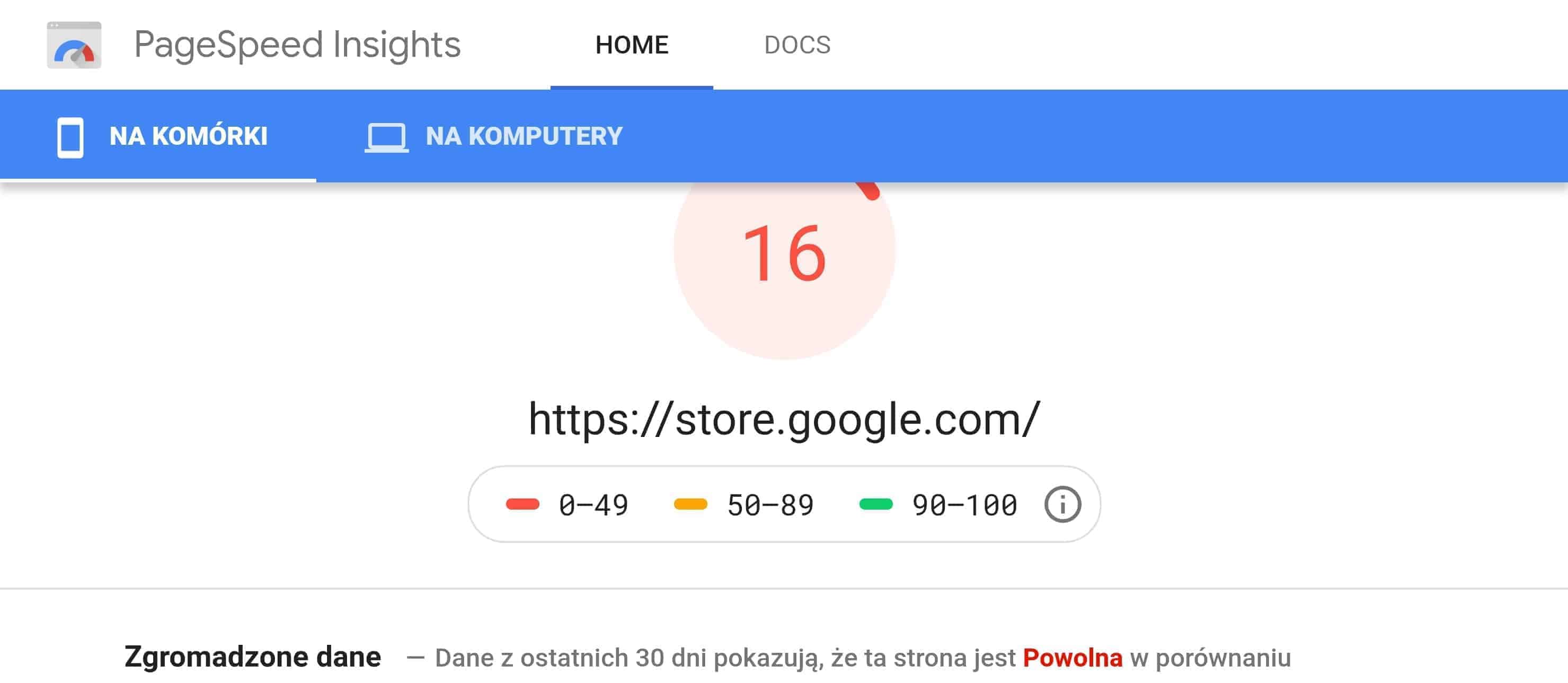

- I wisienka – niektóre strony Google same mają strasznie niską punktacje (o tym również za moment),

Łukasz Szmigiel w sposób kompleksowy rozprawił się z całym tym mitem i „paranoją” 100/100 – tutaj można przeczytać jego artykuł.

A co do Google i tego, że samo nie trzyma się wytycznych swojego narzędzia? Proszę:

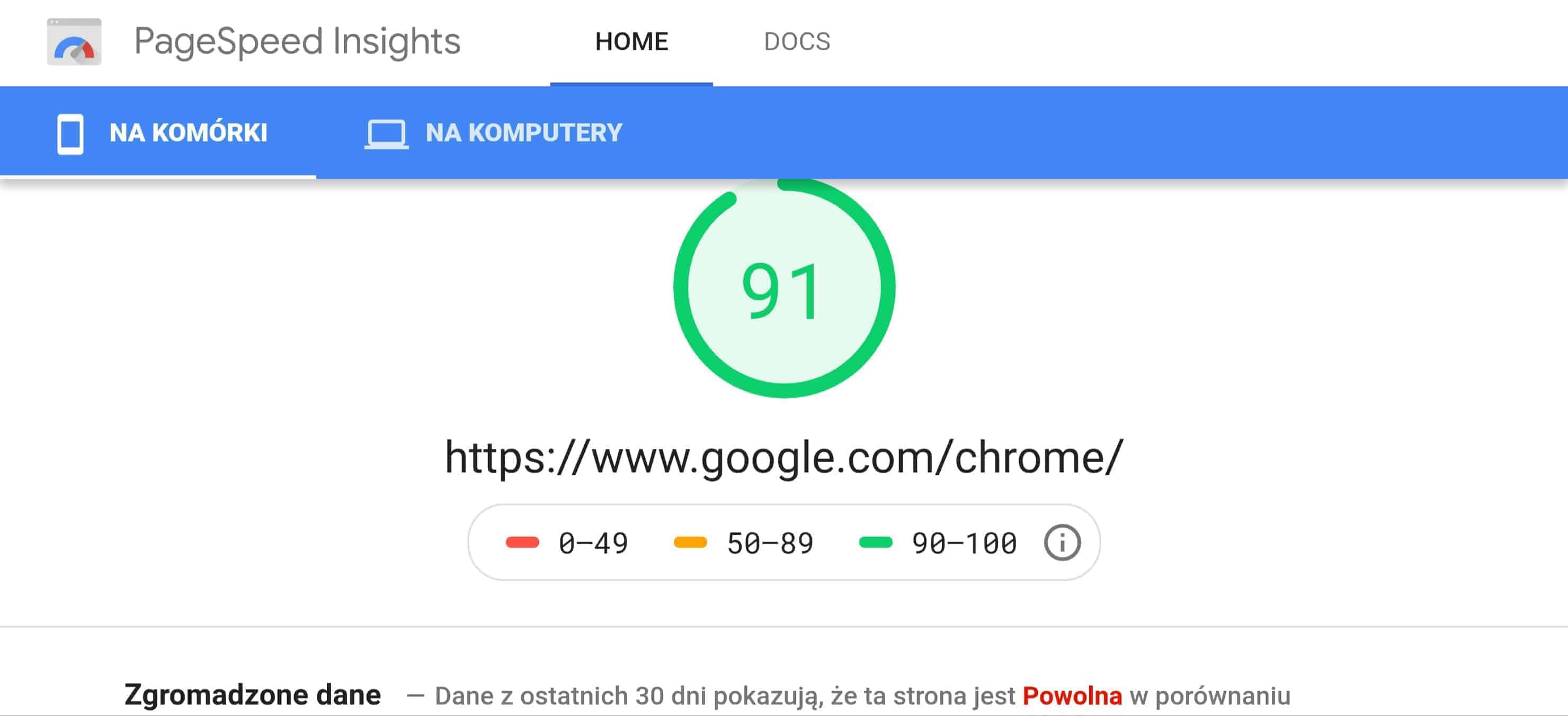

A teraz incepcja – 91 punktów na telefonach i… „strona jest powolna”:

Przeciętny wynik ich głównych stron Adsense, Map, Adwords, Google Play to 50-65 punktów w teście Page Speed Insight.

Zobacz wspomniany artykuł tutaj: Punkty, Punkciki, paranoja

10 komentarzy “Google Page Speed Insight – mit, który sprzedaje SEO”

Janusz Kamiński

Dzięki za temat i link do artykułu. Nawet nie mogłem sobie wyobrazić, że to mit. A co do samych stron Google, nawet gdy one będą fatalne, będą na górze SERPa. :)

Display

Bardzo ciekawe spostrzeżenia. Czyli skupiać się mamy bardziej na treściach oraz linkach?

Jakub Jaworowicz[ Autor Artykułu ]

I na realnej prędkości :) adekwatnej do celu witryny, grupy docelowej i możliwości technicznych.

Yoku

Nareszcie ktoś powiedział prawdę :)

tester

Testowałem trochę na swojej stronie zmiany, które zalecało Google w tym PSI, i u mnie zdecydowanie się te zalecenia nie pokrywały z realną szybkością wczytywania strony. Nie przyszło mi jednak do głowy sprawdzać jak pod tym kątem wypadają narzędzia Google. :D

Krzysztof

Szanuje za opisanie tego – sam z tym walcze od baaardzo dawna :) wartoi zaznaczyc ze algorytm pagespped zmienai sie kilak razy w pmiesiacu i preferuje tworzenei stron PWA – kolejny po AMP bajerek …

Grzegorz durtan

Krzysiek, PWA to nie do końca bajerek, wg. mojej opinii fundamentem PWA jest zapewnienie płynności pracy ze stroną za poziomie aplikacji.

Dopiero wtedy możemy mówić o takich gadżetach jak ikona, czy fullscreen. W związku z powyższym GPSI nie jest taki zły bo przyczynia się do budowania świadomości że szybkość ma znaczenie

szmigieldesign

Cześć!

Dzięki za zalinkowanie do mojego artykułu.

Borykając się z tym tematem zauważyłem jeszcze jedną ciekawostkę. PageSpeed Insights, dla stron o dużym ruchu i dużej ilości danych statystycznych, pokazuje także dane uśrednione. Wystarczy w PSI wpisać takie adresy jak komputronik.pl, gazeta.pl czy allegro.pl. Obserwacje są ciekawe, bo choć pierwsze wyrenderowanie treści w teście syntetycznym dla gazeta.pl wynosi 3.6s dla testu mobilnego – nie ma to potwierdzenia w danych statystycznych, gdzie w 63% przypadków ten parametr jest mniejszy niż 1s, dla 30% przypadków mieści się w granicy 2.5s, a tylko dla 7% odwiedzających wyniósł powyżej 2.5s!

Sprawdźcie sami i pamiętajcie, że PSI to narzędzie mające pomagać w debugowaniu problemów z wydajnością strony, a nie wyrocznia szybka / wolna strona.

Projekt-stron

Witam,

Z racji napisania tego artykułu chciałbym podzielić się też moimi spostrzeżeniami. Co do faktu, że SEO-wcy czy zwykli właściciele stron za wszelką cenę dążą do uzyskania 100 punktów w Google PageSpeed Insights, zgodzę się z autorem – w bardzo łatwy sposób można „przeoptymalizować” stronę i zamiast poprawić jej funkcjonalność otrzymamy zupełnie odwrotny efekt. Ale nie mogę się zgodzić ze stwierdzeniem, że narzędzie to jest całkowicie bezużyteczne. Od jakiegoś czasu narzędzie to oprócz czysto „teoretycznej” analizy z wykorzystaniem silnika Lighthouse, daje nam opcję podglądu wyników danej witryny badanych na podstawie realnych odwiedzin użytkowników. Do tego celu Google PSI stosuje system zwany CrUX (ang. Chrome User Experience Report). Daje nam te same dane co w przypadku Lighthouse, jednak wyznacznikiem jest realny czas ładowania strony dla realnego użytkownika. Stąd też moja opinia, że narzędzie to mocno odzwierciedla realną prędkość strony. Kolejny temat jaki chciałem poruszyć jest fakt, iż w połowie 2021 roku, silniki wyszukujące mają przejść sporą „modernizację”. Ma ona polegać na tym, że witryny lepiej zoptymalizowane pod kątem narzędzi takich jak Google PSI czy GTMetrix, będą też lepiej pozycjonowane. Osobiście myślę, że należy znaleźć „złoty środek” pomiędzy optymalizacją i funkcjonalnością strony, ale z pewnością nie należy bagatelizować narzędzia Google PageSpeed Insights, nie bez powodu jest ono sygnowane logiem Google :)

Pozdrawiam

Rafał

Zgadzam się w 100%, z resztą jest wiele testów w necie np na backlinko, kiedy wgrali mega wielkie zdjęcia i obciążyli stronę dodatkowo na różne sposoby, odczekali kilka tygodni i nie było zmian w serpach